Bienvenue dans cette édition #06 de la newsletter du Cercle IA, la première de l’année 2026. Je vous souhaite une excellente année, riche en apprentissages et en expérimentations.

Et quel meilleur moment pour franchir un cap symbolique : vous êtes désormais plus de 1 000 à suivre cette newsletter. Merci à toutes celles et ceux qui lisent, partagent et commentent depuis le lancement.

« Quel est le meilleur modèle d’IA ? ».

C’est LA question qui revient à chaque formation IA que je donne. Parfois formulée autrement : « Je devrais utiliser ChatGPT ou Claude ? », « Est-ce que Gemini 3 est mieux que GPT-5.2 ? », « Mistral, ça vaut le coup ? ».

Ma réponse déçoit souvent : « Ça dépend. »

Pas parce que je refuse de trancher.

Mais parce qu’elle part d’un postulat erroné : qu’il existerait un “meilleur” modèle, universel, optimal pour tous les usages.

C’est comme demander quel est le meilleur athlète olympique. Le sprinter ? Le marathonien ? Le lanceur de javelot ? La réponse dépend de l’épreuve.

Pour illustrer mon propos, je vais remonter jusqu’à l’Antiquité grecque et à l’origine des Jeux olympiques.

Dans cette édition :

Le podium ne dit pas tout : pourquoi les classements d’IA sont utiles mais insuffisants ;

Les disciplines olympiques de l’IA : comprendre où chaque modèle excelle ;

Les 7 formes de “dopage” : ce qui fausse les benchmarks et les classements ;

L’outil à tester : LMarena, l’arène où vous jugez les modèles vous-même.

De l’Olympie antique aux arènes numériques

776 avant J.-C., Olympie, Grèce.

Coroebus d’Élis franchit la ligne d’arrivée du stadion, une course de 192 mètres. Il devient le premier champion olympique de l’histoire. Pour les Grecs anciens, cette victoire le consacre comme l’homme le plus rapide du monde.

Mais était-il le meilleur athlète ?

Les Grecs savaient déjà que non.

C’est pourquoi ils ont créé le pentathlon : course, saut en longueur, lancer du disque, lancer du javelot, lutte. Le vrai champion, pensaient-ils, devait exceller dans plusieurs disciplines.

Et même cette mesure était imparfaite. Car le meilleur pentathlète n’était pas nécessairement le meilleur pour votre cité, pour votre guerre, ou pour votre besoin spécifique.

Cette obsession de la mesure objective a traversé les millénaires. Elle s’est incarnée dans la devise olympique :

Citius, Altius, Fortius : plus vite, plus haut, plus fort.

Les benchmarks IA : l’obsession de mesurer l’intelligence des modèles IA

Aujourd’hui, nous faisons face à un défi similaire avec l’intelligence artificielle : comment mesurer et comparer l’intelligence de machines ?

Contrairement à un sprinter, on ne peut pas simplement chronométrer une IA. L’intelligence n’est pas unidimensionnelle. Elle ne se réduit pas à une seule performance.

C’est pourquoi les chercheurs ont créé des benchmarks, des tests standardisés pour mesurer différentes capacités des modèles d’IA) :

Compréhension du langage

Raisonnement logique

Génération de code

Analyse visuelle

Créativité

Honnêteté

Comme aux Jeux Olympiques, ces benchmarks organisent des épreuves et classements. Et les laboratoires d’IA (OpenAI, Anthropic, Google, Meta, Mistral…) s’affrontent pour décrocher la première place.

Comme les JO ont standardisé la mesure de la performance athlétique, les benchmarks tentent de standardiser la mesure de la performance IA.

Mais attention : cette analogie révèle aussi les limites du système.

2025, arènes numériques

Poser la question “quel est le meilleur modèle d’IA ?”, ça équivaut à demander : “qui était le meilleur athlète de l’Antiquité ?”

La réponse n’a pas changé en 2800 ans : ça dépend de la discipline et du contexte.

2018-2020 : L’ère du “stadion” (GLUE benchmark)

GLUE est l’acronyme de General Language Understanding Evaluation (Évaluation de la Compréhension Générale du Langage. GLUE est lancé en janvier 2018 via un article académique publié par un groupe de recherche mené par Alexandr Wang (qui avait seulement 21 ans et qui a été nommé directeur de la recherche IA de Meta en 2025).

L’ambition était simple, mais ambitieuse pour l’époque : mesurer la compréhension réelle du langage naturel par les modèles d’IA.

Pas la capacité à générer du texte fluide, mais la capacité à comprendre.

Comme le stadion, les premiers benchmarks mesuraient une chose : la compréhension du langage.

Mais comme le décathlon, GLUE soumettait les modèles à plusieurs épreuves : une suite de neuf tâches diversifiées, incluant notamment l’analyse de sentiment, la similarité textuelle, et l’acceptabilité linguistique.

Le problème ? Excellente compréhension ≠ bon raisonnement ≠ bon code ≠ bonne créativité.

Autrement dit, courir vite ne fait pas de vous un bon lanceur de javelot.

2020-2023 : L’ère du pentathlon (diversification des benchmarks)

La communauté IA a reconnu que les modèles avaient plusieurs « muscles » à mesurer. Les benchmarks se sont multipliés :

Comme les Grecs ajoutant le pentathlon, les chercheurs ont réalisé qu’un bon modèle IA devait exceller sur plusieurs fronts:

MMLU : connaissances générales (57 domaines, du droit à la médecine) ;

HumanEval : génération de code ;

BBH : raisonnement complexe ;

HELM : évaluation holistique sur 42 scénarios

2023-2025 : l’ère des Jeux modernes de l’IA (explosion des spécialisations)

2023-2025 : L’ère des Jeux modernes

À l’instar des JO de Paris 2024 qui ont réuni 32 sports regroupés en 43 disciplines et 329 épreuves au total, on recense aujourd’hui plus de 50 benchmarks de modèles IA.

Et il n’existe pas de modèle IA champion universel. Chaque discipline révèle son propre podium.

Voici un aperçu des principaux benchmarks utilisés pour évaluer les modèles d’IA :

Ce tableau couvre l’essentiel des dimensions évaluées : tâches professionnelles, raisonnement mathématique, programmation, sciences, multimodalité, contexte long, éthique, langues et jugement humain.

Sept formes de « dopage » des modèles IA

Ben Johnson, 1988, Séoul. Record du monde du 100 mètres. Médaille d’or. Puis déchéance : contrôle antidopage positif, titre retiré.

Dans le sport, le dopage fausse la compétition. Dans l’IA, des pratiques comparables biaisent les benchmarks :

Contamination des données (data contamination) : les modèles ont souvent vu les questions des benchmarks pendant leur entraînement. Ils ne raisonnent plus, ils récitent. Les scores élevés reflètent une mémoire de l’examen, pas une capacité réelle.

Sur-apprentissage des benchmarks (overfitting to benchmarks) : les modèles sont ajustés de plus en plus finement pour réussir des tests précis, au détriment de leur comportement hors benchmark. Ils excellent sur l’épreuve officielle, mais peinent dès que le format, le style ou la distribution des questions change. C’est l’équivalent d’un athlète entraîné pour une seule piste, incapable de performer ailleurs.

Sélection stratégique des résultats (cherry-picking) : les laboratoires mettent en avant les benchmarks favorables et ignorent les autres, créant une illusion de supériorité globale.

Biais de conception des benchmark (Benchmark design bias) : certains tests sont construits de manière à avantager certaines architectures ou familles de modèles. Le gagnant est partiellement déterminé par l’épreuve elle-même.

Absence d’arbitrage et de gouvernance (lack of proctoring and governance): il n’existe ni arbitrage, ni limitation du nombre de tentatives, ni procédure de recours. Les équipes peuvent ajuster leurs modèles sur les tests et sélectionner les résultats publiés, sans contrôle.

Saturation et obsolescence des benchmarks (benchmark saturation and staleness) : beaucoup de benchmarks restent figés alors que les modèles progressent vite. Une fois saturés, ils continuent pourtant à être cités, donnant une image trompeuse du niveau réel des systèmes.

Biais des données et domination linguistique (data bias and language dominance): la surreprésentation de l’anglais et de certaines cultures fausse les résultats. Sans datasets multilingues, diversifiés et soumis à un contrôle qualité unifié, l’évaluation reste inéquitable.

Ces failles brouillent le signal scientifique. Les chercheurs écrivent que les pratiques actuelles d’évaluation sont un « champ de mines ».

SOTA : le podium mouvant des modèles IA de pointe

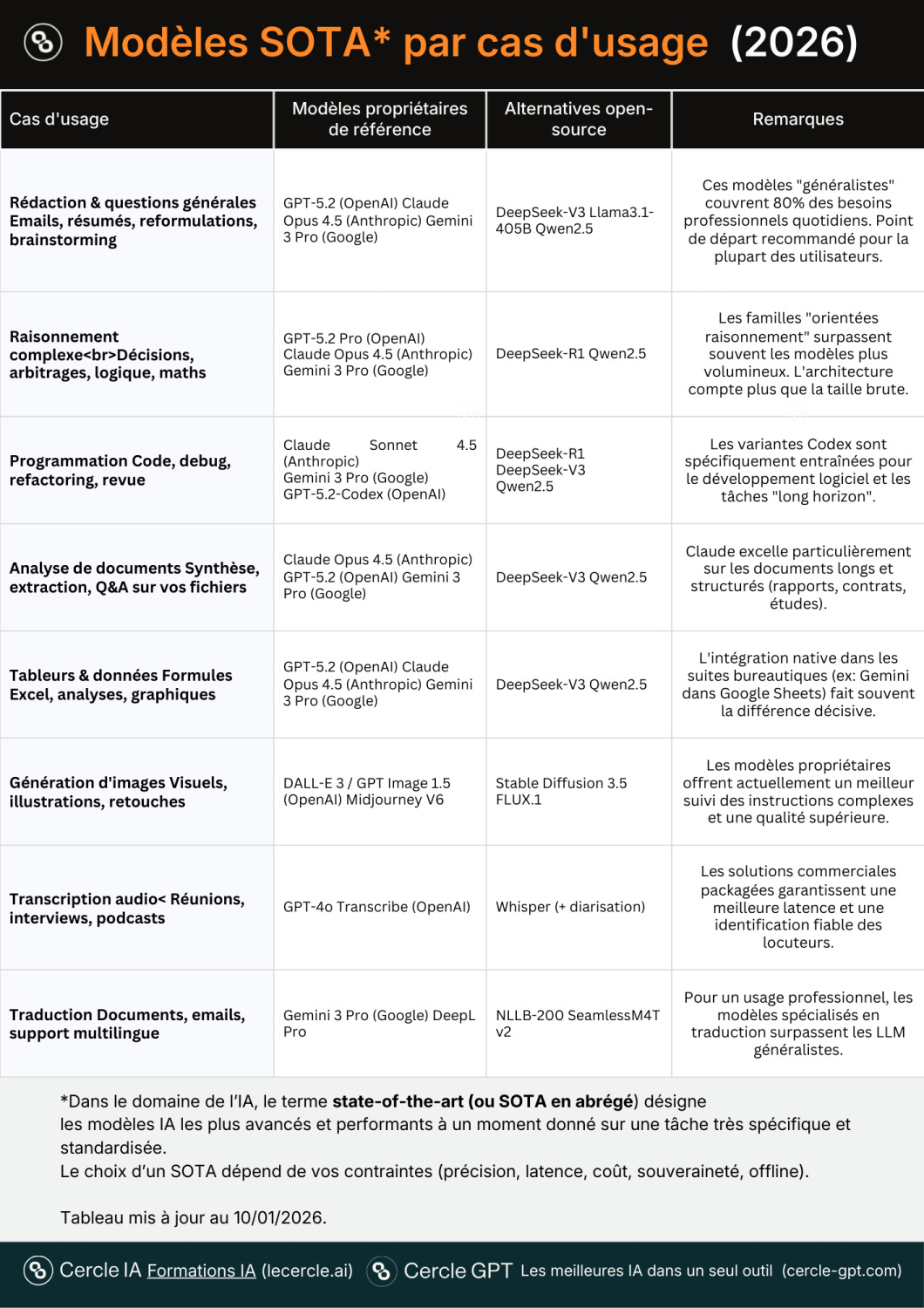

Dans le domaine de l’IA, le terme state‑of‑the‑art (ou SOTA en abrégé) est utilisé pour désigner les modèles IA les plus avancés et performants à un moment donné sur une tâche très spécifique et standardisée.

C’est un titre très disputé et en évolution perpétuelle, avec de nouveaux prétendants qui émergent constamment pour s’emparer de la première place.

Ces modèles définissent les meilleurs niveaux de performance atteignables pour une tâche donnée (raisonnement, reconnaissance d’image, synthèse vocale, etc.).

Modèles SOTA par cas d’usage (en janvier 2026)

L’outil IA de la semaine : LMarena

Comment savoir quel modèle d’IA est vraiment le meilleur ? Pas en lisant les communiqués de presse des laboratoires. En demandant aux utilisateurs.

C’est exactement ce que fait LMarena (anciennement Chatbot Arena), une plateforme créée par des chercheurs de l’Université de Californie à Berkeley.

LMarena publie un classement des modèles d’IA basé sur plus de 5 millions de votes d’utilisateurs réels. Le principe est simple : deux modèles anonymes répondent à la même question, vous choisissez la meilleure réponse, et votre vote alimente un score Elo (comme aux échecs).

Ce classement a trois avantages sur les benchmarks traditionnels :

Il reflète l’usage réel. Pas des tests de laboratoire, mais des préférences humaines sur des conversations authentiques.

Il est mis à jour en continu. Chaque nouveau modèle est testé par des milliers d’utilisateurs dans les jours qui suivent sa sortie.

Il permet de filtrer par catégorie. Vous pouvez voir quel modèle est le plus performant en code, en raisonnement, en créativité, ou en français.

Testez vous-même

Au-delà du classement, LMarena vous permet de comparer les modèles directement :

Mode Battle : posez une question, deux modèles anonymes répondent, vous votez. Les identités sont révélées après.

Mode Direct : accédez gratuitement à GPT-4o, Claude, Gemini et d’autres, sans abonnement.

Mon conseil : consultez le classement pour identifier les leaders actuels. Puis passez 15 minutes en mode Battle avec des questions de votre quotidien professionnel. Vous verrez vite si le “meilleur” modèle du classement est aussi le meilleur pour vos besoins.

Accéder à LMarena (classements) : https://lmarena.ai/fr/leaderboard (gratuit, sans inscription)

Avant de nous quitter, une nouvelle à partager :

Cercle GPT en phase bêta. C’est l’outil IA que j’ai développé pour réunir les meilleurs modèles IA dans un espace sécurisé et adapté aux professionnels francophones. Il est actuellement déployé à l’IHECS en Master 2 et auprès d’un groupe d’utilisateurs dans des secteurs comme le conseil, la communication et l’enseignement.

Si vous souhaitez rejoindre gratuitement la bêta et tester Cercle GPT, vous pouvez vous inscrire ici

À bientôt, et n’oubliez pas de mettre vos connaissances en pratique.

Tarik Hennen

Formateur & Consultant IA – Cercle IA

Cette 6ème édition vous a plu ? Trois actions simples :

✅ Abonnez-vous pour recevoir les prochaines analyses ;

✅ Partagez cette newsletter ;

✅ Laissez un commentaire ou posez une question.