Bienvenue dans cette édition #04 de la newsletter du Cercle IA. Merci aux 90 nouveaux abonnés (vous êtes désormais 805 à suivre cette newsletter).

La rentrée académique vient d’avoir lieu dans le supérieur. Vous voyez donc venir la question :

est-ce que l’IA générative trouve sa (juste) place dans l’enseignement en Belgique ?

Un constat alarmant :

Juin 2025. Une institution d’enseignement supérieur belge (que je ne nommerais pas pour ne pas tirer sur l’ambulance) consulte un groupe de professionnels de l’IA auquel je suis convié pour évaluer un cursus complet dédié à l’Intelligence Artificielle.

Le constat est sans appel : le programme ignore presque totalement l’IA générative.

Pour les étudiants qui viennent de faire leur rentrée dans ce programme, soit trois ans après la sortie de ChatGPT, la douche risque d’être froide lorsqu’ils arriveront sur le marché du travail.

On pourrait croire qu’il s’agit d’un cas isolé. Mais de nombreuses institutions de l’enseignement supérieur n’ont pas encore intégré l’IA de façon adéquate.

Dans cette édition :

- Le symptôme belge : pourquoi la peur paralyse l’innovation éducative ;

- Comparaison internationale : comment nos voisins français et anglais prennent l’avantage ;

- Le coût de l’inaction : les risques cachés à ne rien faire ;

- L’outil à tester : avec Napkin AI, transformez vos idées en visuels percutants.

Le symptôme belge : quand la peur paralyse l’innovation éducative

Alors que l’IA est omniprésente, de nombreuses écoles et universités semblent rester au point mort.

Je me suis demandé pourquoi.

Pour y répondre, partons du document officiel « Intelligence artificielle & enseignement : principes d’application » publié par la Fédération Wallonie-Bruxelles (« FWB ») publié en août 2025.

L’ambition déclarée de la FWB ? Proposer un « cadre de référence commun pour baliser l’utilisation de ces outils technologiques dans un contexte éducatif. Ce document vise à garantir le respect des valeurs ainsi que des impératifs éthiques et légaux dans l’Enseignement obligatoire, l’Enseignement pour Adultes et l’Enseignement supérieur. Cette ressource peut servir de base utile à l’élaboration d’instruments d’autorégulation propres à chaque établissement. » (soulignement ajouté)

Dans cette brochure de 12 pages, 85% du texte se concentre sur ce qu’il faut éviter de faire avec l’IA.

Ce qu’on y trouve en abondance :

- Énumération des risques

- Rappels RGPD et droit d’auteur

- Mises en garde contre les biais

- Alertes sur la dépendance technologique

Ce qu’on y cherche en vain :

- Comment intégrer concrètement l’IA dans l’enseignement

- Quelles méthodes pédagogiques adopter, quels cas d’usage encourager,

- Comment former les enseignants

- Quelles ressources mettre en place, quels objectifs, comment évaluer les progrès,

Le problème de fond : Ces « principes » de la FWB ressassent des évidences que tout professionnel de l’enseignement devrait déjà maîtriser. Rappeler qu’il faut respecter le RGPD ou éviter les biais, c’est comme rappeler à un médecin de se laver les mains.

Et seules quelques lignes sont dédiées aux apprenants … et les potentialités de l’IA sont mentionnées de façon laconique.

Le résultat ? C’est comme donner un code de la route à un jeune conducteur sans lui expliquer comment conduire.

Un approche belge en rupture avec les orientations de l’UNESCO et de la Commission européenne

Cette approche belge contraste fortement avec les orientations internationales (auxquelles la FWB fait pourtant référence).

L’UNESCO a publié en 2023 ses « Orientations pour l’IA générative dans l’éducation et la recherche ». La Commission européenne multiplie les recommandations depuis 2021.

Lancé en juin 2022, l’European Digital Education Hub (EDEH) est une initiative de la Commission européenne visant à accompagner la transformation numérique de l’éducation en Europe. Avec plus de 7 000 membres issus de divers secteurs, 31 équipes thématiques spécialisées et plus de 150 publications, cette plateforme a produit un consensus robuste sur l’intégration de l’IA en éducation.

Dans son « AI Report » publié en 2023, l’EDEH articule un cadre complet et pragmatique pour l’intégration responsable de l’intelligence artificielle dans les systèmes éducatifs, en abordant les compétences des enseignants, les enjeux éthiques, juridiques et pédagogiques.

Ce rapport fait autorité car il est élaboré avec l’expertise conjointe d’acteurs européens de premier plan, s’aligne sur les normes européennes comme l’AI Act, et propose des recommandations opérationnelles équilibrées pour une adoption sécurisée et éthique de l’IA dans l’éducation.

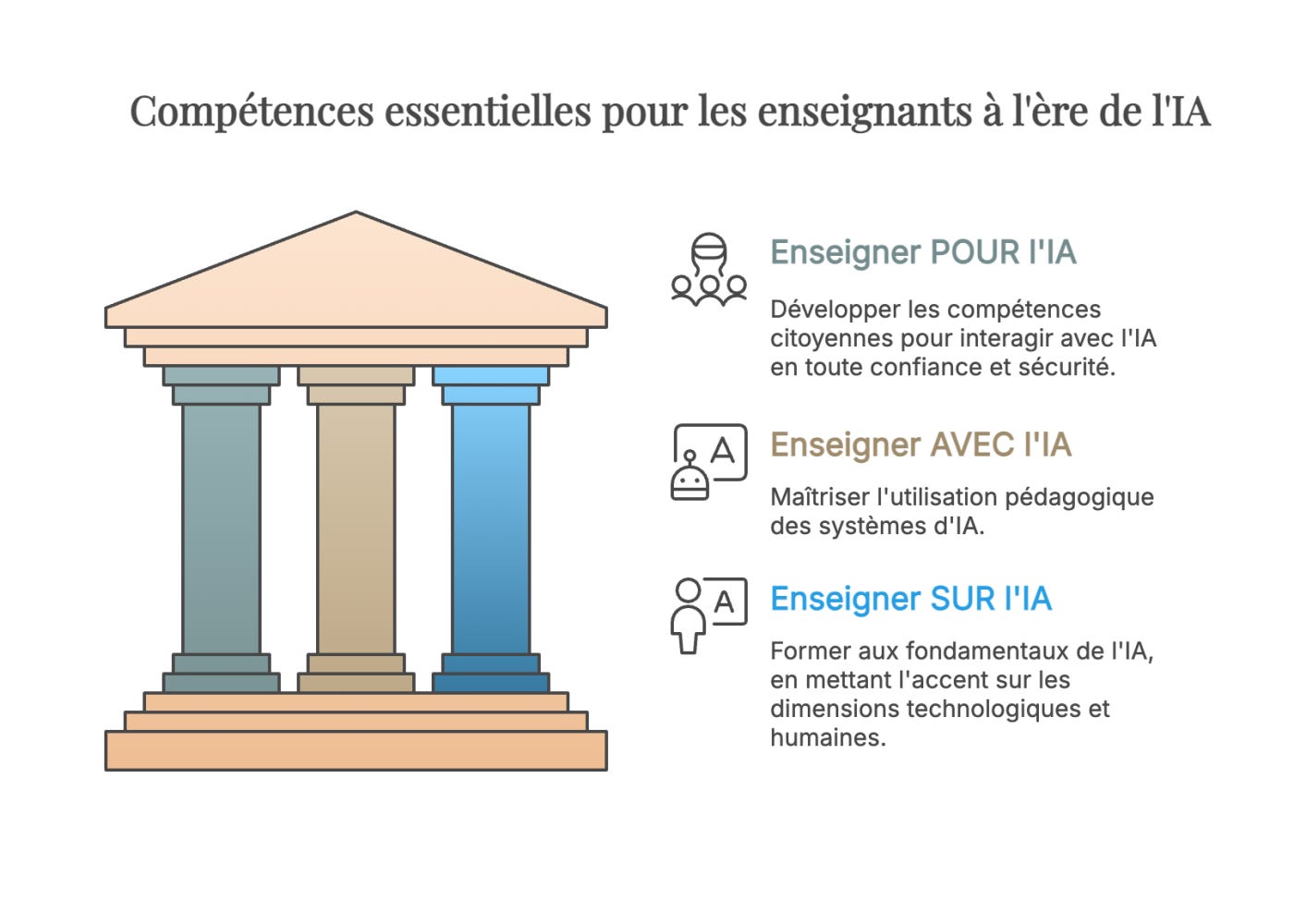

Trois piliers de compétences des enseignants : enseigner par, pour et avec l’IA

Une évidence s’impose : on ne peut attendre de résultats positifs dans l’apprentissage des étudiants sans une vision claire des compétences que les enseignants doivent développer pour répondre aux défis de l’IA.

En la matière, le rapport EDEH présente trois piliers de compétences pour les enseignants :

- Enseigner POUR l’IA (Teaching for AI) : Développer les compétences citoyennes fondamentales pour tous (enseignants et apprenants) afin d’interagir avec confiance, esprit critique et sécurité avec les systèmes d’IA. L’objectif : acquérir les connaissances, compétences et attitudes nécessaires pour vivre dans un monde façonné par l’IA.

- Enseigner AVEC l’IA (Teaching with AI) : Maîtriser l’utilisation pédagogique des systèmes d’IA. Cela implique de développer le jugement pédagogique pour savoir quand les utiliser, mais aussi comprendre le fonctionnement des algorithmes sous-jacents, des modèles pédagogiques et des données qui les alimentent.

- Enseigner SUR l’IA (Teaching about AI) : La dimension plus technique, centrée sur la formation aux fondamentaux de l’IA. Cette « littératie IA » doit englober à la fois les dimensions technologiques et humaines de l’IA, adaptées selon l’âge des étudiants.

Visuel réalisé par l’auteur avec Napkin AI.

Plutôt que de relayer les travaux de l’EDEH, la FWB a préféré une approche de « co-construction avec les Fédérations de Pouvoirs organisateurs et Wallonie-Bruxelles Enseignement (WBE). Dans une démarche inter-réseaux, les contributrices et contributeurs (conseillères et conseillers technopédagogiques et pédagogiques; agentes et agents du Service général du Numérique éducatif) ont croisé leur expertise et leur regard sur des réalités de terrain, afin de faire émerger un référentiel commun. »

Le paradoxe belge ? Nous avons accès à cette expertise européenne documentée et validée par plus de 7 000 professionnels, mais chaque institution préfère réinventer la roue.

Résultat ? Un patchwork de solutions bricolées plutôt qu’une stratégie cohérente basée sur les meilleures pratiques internationales.

Belgique, France, Royaume-Uni : trois approches de l’IA en éducation

Belgique (Fédération Wallonie-Bruxelles) : le manuel de conformité

La Fédération Wallonie-Bruxelles a choisi l’angle de la prudence maximale. Le document officiel aligne règles et interdits : RGPD, droit d’auteur, supervision humaine, sobriété numérique. Mais il laisse les enseignants sans véritables outils pratiques.

Résultat : l’IA est perçue surtout comme une menace à contrôler plutôt qu’un levier pédagogique.

France (Éducation nationale, 2025) : le mode d’emploi officiel

Le gouvernement français a publié un « cadre d’usage de l’intelligence artificielle (IA)” en éducation visant à donner une “réponse concrète et attendue face à la diffusion massive des outils d’IA générative dans la société, en particulier parmi les élèves”.

Le texte de 18 pages présente les potentialités de l’IA avant les risques de l’IA. L’approche est plus opérationnelle que celle de la Belgique.

En France, l’usage de l’IA est autorisé en éducation dès lors qu’il respecte le cadre défini : formation obligatoire des élèves (4e, 2de, CAP), expérimentation encadrée par les enseignants, transparence exigée dans l’usage.

On reconnaît que l’IA est déjà là et qu’il faut l’intégrer, mais dans un cadre rigide.

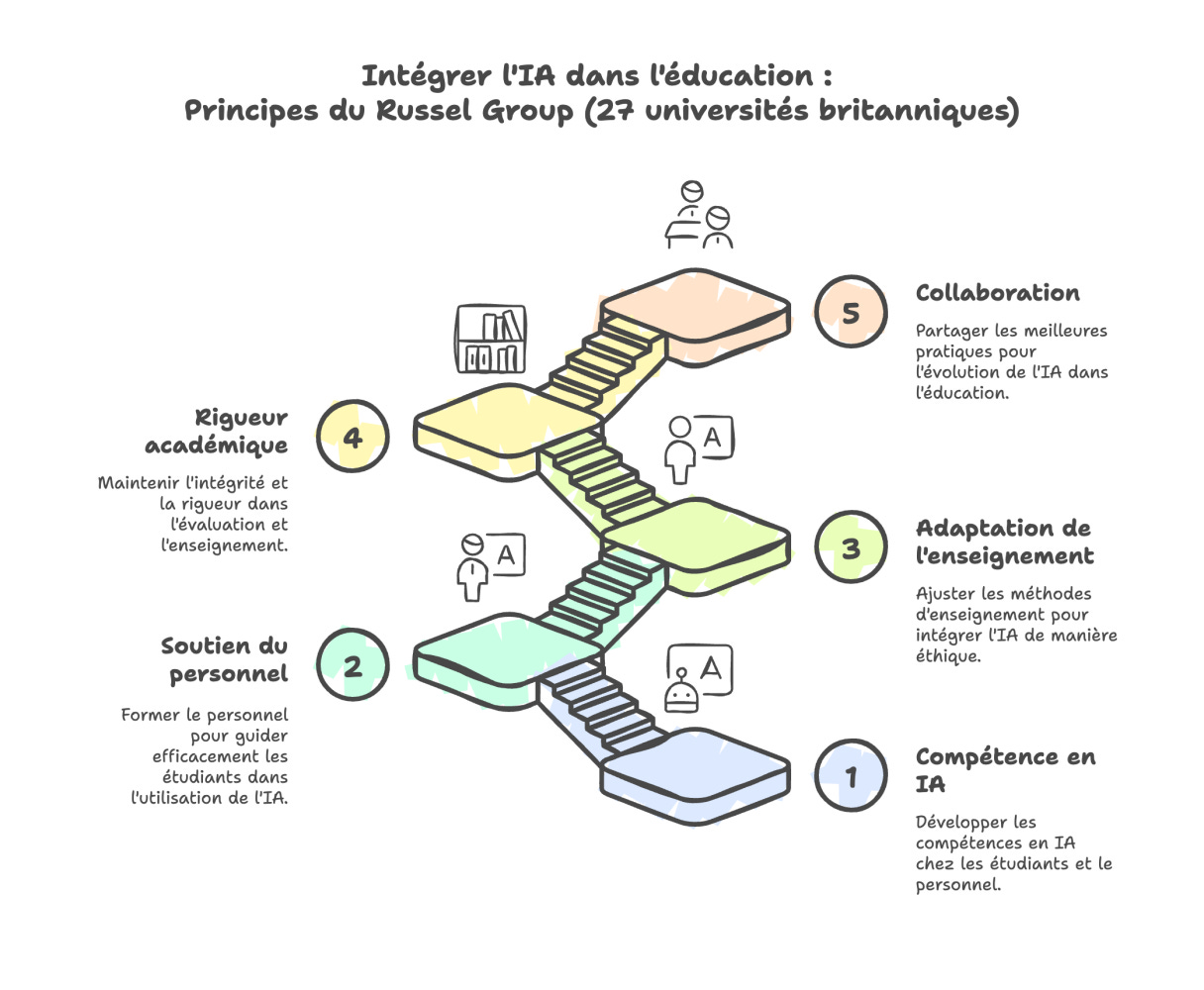

Royaume-Uni : un cadre pour saisir les opportunités

Outre-Manche, ce ne sont pas les autorités publiques qui ont donné le ton, mais les universités d’élite elles-mêmes. En 2023 déjà, le Russell Group, une association qui rassemble les 24 principales universités de recherche britanniques (Oxford, Cambridge, Imperial College, etc.), a publié un cadre commun d’utilisation de l’IA générative.

L’accent n’est pas mis sur les interdits, mais sur l’intégration active : l’IA est reconnue comme une compétence incontournable que chaque étudiant devra maîtriser.

Le plan d’action du Russel Group tient en seulement 3 pages et repose sur cinq piliers qu’on peut traduire comme ceci :

- Les universités aideront les étudiants et le personnel à devenir compétents en IA (AI-literate) ;

- Le personnel doit être en mesure d’accompagner les étudiants dans l’utilisation des outils d’IA générative, de manière efficace et appropriée dans leur apprentissage ;

- Les universités adapteront l’enseignement et l’évaluation afin d’intégrer l’usage éthique de l’IA générative et de garantir un accès équitable ;

- Les universités veilleront à maintenir la rigueur académique et l’intégrité ;

- Les universités collaboreront pour partager les meilleures pratiques à mesure que la technologie et ses applications dans l’éducation évoluent.Visuel réalisé par l’auteur avec Napkin AI.

En août 2025, le gouvernement britannique a publié un plan visant à intégrer l’IA à grande échelle dans l’éducation pour moderniser l’apprentissage, alléger la charge des enseignants et personnaliser le suivi des élèves. Il repose sur la formation des enseignants, un encadrement strict et des mécanismes de gouvernances pour garantir la sécurité, la transparence et l’éthique. En parallèle, ce plan s’inscrit dans une stratégie nationale plus large intitulée AI Opportunities Action Plan.

Le message est clair :

- Former plutôt qu’interdire : les universités s’engagent à enseigner aux étudiants comment utiliser l’IA de manière responsable, critique et transparente ;

- Expérimenter à grande échelle : les professeurs sont encouragés à repenser leurs méthodes d’évaluation et leurs cours pour inclure des usages pratiques de l’IA ;

- Préparer à l’employabilité : le cadre souligne que l’IA fait déjà partie du monde du travail et que les diplômés doivent sortir prêts à l’utiliser dans leur futur métier.

Résultat : le Royaume-Uni s’affiche comme précurseur, avec une approche proactive qui cherche à donner un avantage compétitif à ses étudiants sur le marché international.

Trois visions, trois vitesses :

- La Belgique freine (« Ne faites pas d’erreurs avec l’IA ») ;

- La France avance avec le frein à main (« Faites avec l’IA, mais sous conditions strictes ») ;

- Le Royaume-Uni accélère. « Innovez, expérimentez, partagez »

La question : faut-il miser sur le lièvre ou la tortue ?

Les risques de l’inaction

Ne rien faire n’est pas neutre. C’est un choix qui porte des conséquences :

- Premier risque : sacrifier les chances de nos étudiants. Dans trois ans, ils affronteront un marché du travail redessiné par l’IA avec des compétences d’hier ;

- Deuxième risque : laisser les enseignants démunis. Sans cadre structurel, ils sont relégués à bricoler des solutions individuelles ;

- Troisième risque : creuser notre retard concurrentiel. Pendant que nous débattons, nos voisins forment une génération d’experts IA ;

- Quatrième risque : le piège de la formation technique en silo. Beaucoup d’institutions tombent dans ce piège : créer un cours d’IA distinct, enseigné par le département informatique, déconnecté des applications métier.

Une approche alternative : reconnaître que l’IA est partout (comme le fait la France) et donc l’intégrer l’IA dans chaque discipline (conformément aux directives internationales), avec des cas d’usage concrets et des applications pratiques (le bon sens).

Message aux décideurs belges (s’ils ou elles me lisent)

Trois actions urgentes :

- Sortez de la logique de conformité. Passez du comment éviter les risques » au « comment saisir les opportunités » (sans perdre de vue les risques) ;

- Inspirez-vous des consensus internationaux. L’UNESCO et la Commission européenne ont fait le travail. Utilisez-le ;

- Formez massivement. Enseignants d’abord, étudiants ensuite. Sans formation de qualité, tous les beaux principes restent lettre morte.

A défaut, nous risquons de voir nos voisins former les talents que nos entreprises seront contraintes de recruter dans un avenir proche.

L’outil de la semaine : Napkin AI

« Un bon croquis vaut mieux qu’un long discours”

Cette maxime de Napoléon Bonaparte résonne particulièrement aujourd’hui. Dans nos présentations, nos rapports, nos explications, nous multiplions les mots en espérant être compris. Mais combien de fois avons-nous vu des yeux se voiler d’incompréhension malgré nos efforts ?

Napkin AI transforme cette frustration en opportunité. L’outil analyse automatiquement vos textes et génère instantanément des visuels clairs qui rendent votre message immédiatement compréhensible.

Le processus est d’une simplicité déconcertante : vous collez votre texte. Napkin comprend automatiquement la structure de vos idées. En quelques secondes, l’outil génère diagrammes, infographies ou cartes mentales adaptés à votre contenu. Vous personnalisez le design selon vos besoins, et votre visuel professionnel est prêt.

Pourquoi il faut tester Napkin AI :

- Génère en quelques secondes un visuel impactant à partir de vos textes ;

- Design professionnel sans compétences graphiques ;

- Parfait pour les présentations, rapports et visuels pour les réseaux sociaux.

>Testez Napkin AI gratuitement

Cette semaine, choisissez une idée complexe que vous devez expliquer. Transformez-la avec Napkin. Observez la différence dans les réactions de votre audience.

Trois ans après ChatGPT, nous avons le choix :

Option 1 : Continuer à débattre des risques et à attendre pendant que d’autres forment les talents de demain.

Option 2 : Prendre les devants, individuellement et collectivement.

Avant de nous quitter, j’ai deux nouvelles à partager avec vous :

- Je rejoins l’IHECS comme professeur invité pour donner un séminaire de professionnalisation à l’ère de l’IA en Master 2 du département Relations Publiques. Je suis très heureux d’avoir l’opportunité de contribuer à l’enseignement de l’IA.

- Lancement de la 2ème cohorte du Bootcamp IA le 16 octobre prochain. Réservez dès maintenant votre place pour ce programme de formation IA pour professionnels du conseil, dirigeants et professions libérales.

Cette 4ème édition vous a plu ? Trois actions simples :

✅ Abonnez-vous pour recevoir les prochaines analyses

✅ Partagez cette newsletter à un contact qui s’intéresse à l’IA

✅ Laissez un commentaire ou posez nous une question.

À bientôt et n’oubliez pas de mettre vos connaissances en pratique.